OneDrive, Dropbox, irgendwelche VPN-Anbieter oder der Google Passwortspeicher. Es handelt sich dabei um Dienste, welche bereits seit vielen Jahren Bestandteil unseres Lebens sind. Doch dabei macht sich kaum jemand Gedanken über die Sicherheit der eigenen Daten. In einem Selbstversuch – und auch weil diverse Dienste für mich in Zukunft deutlich dezentraler betrieben werden sollen – habe ich diverse Dienste auf die Selfhosting-Variante umgestellt. Aber ist das eine Lösung für die breite Masse?

Was sind die Vor- und Nachteile?

Die Vorteile für den Eigenbetrieb liegen auf der Hand. Man behält die Kontrolle über die eigenen Daten und Dienste, kann diese an die eigenen Bedürfnisse anpassen und erreicht insgesamt eine deutlich höhere Datensicherheit – sofern die Konfiguration stimmt. Und genau hier liegt oft der Hase im Pfeffer. Bei meinen Recherchen zu diesem Artikel bin ich auf die unterschiedlichsten IT-Systeme gestoßen, teils von Firmen, teils von Privatpersonen, die offen im Internet stehen. Die Bandbreite reichte von fast noch harmlosen Dingen wie ungeschützten Druckern bis hin zu völlig ungeschützten NAS-Systemen in Privathaushalten mit teilweise sehr persönlichen Daten aus dem Gesundheitsbereich, Gehaltsabrechnungen oder Fotos aus dem letzten Urlaub. Entsprechende Kompetenzen sind daher für den Eigenbetrieb unbedingt erforderlich, insbesondere wenn die Dienste öffentlich über das Internet erreichbar sein sollen. Zudem benötigt man für den Betrieb zu Hause einen DynDNS-Dienst bzw. eine Domain für den Betrieb von Diensten auf einem Cloud- bzw. dedizierten Server.

Darüber hinaus gilt es natürlich auch, die Kosten für den Internetanschluss, die benötigte Hardware und deren Wartung sowie den Stromverbrauch zu berücksichtigen. Alles in allem eine Entscheidung, die nicht überstürzt getroffen werden sollte. Hat man sich allerdings dafür entschieden, stellt sich auch die Frage, wo fängt man an. Zeige ich einmal meinen Weg auf, welchen ich gewählt habe.

Die Grundlage für viele Dienste: Docker

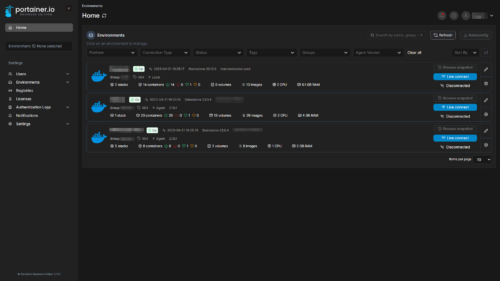

Docker ist ebenfalls eine Open-Source-Plattform, die für eine Vielzahl von Systemen zur Verfügung steht. Sie ermöglicht es, Anwendungen in Containern isoliert vom eigenen Hostsystem zu betreiben. Mit dieser Methode lassen sich Dienste oft schnell und ohne großen Konfigurationsaufwand selbst ausrollen. Zudem können Updates der einzelnen Container über Watchtower auf Wunsch mit zahlreichen zur Verfügung stehenden Parametern automatisiert werden. Da Docker von Haus aus nur auf der Kommandozeile funktioniert, kann man sich hierbei optional der Software Portainer bedienen. Diese bringt eine grafische Oberfläche mit sich und erleichtert gerade Einsteigern in Docker das Ausrollen und die Verwaltung von Diensten doch erheblich. Portainer selbst ist in einer Community- aber auch einer kostenpflichtigen Business-Variante im Abo nutzbar. Ich selbst nutze aufgrund des größeren Funktionsumfangs selbst die Business-Variante, welche sich mit bis zu fünf Nodes kostenfrei nutzen lässt.

NGINX Proxy-Manager: SSL und Zugriffsbeschränkung einfach gemacht

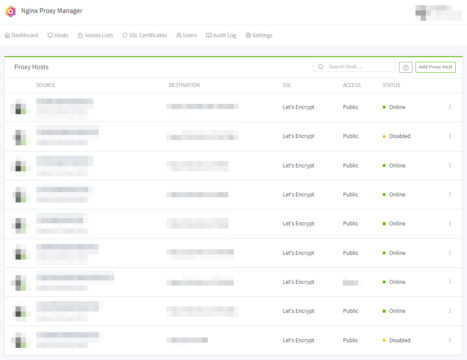

Der NGINX Proxy Manager wird erwartungsgemäß schnell und komfortabel in Form eines Docker-Containers ausgeliefert. Nach der Installation kann die Administrationsoberfläche im Browser über die IP-Adresse und den definierten Port aufgerufen werden. Die Default-Login-Daten (admin@example.com – changeme) müssen nach dem ersten Login geändert werden. Danach kann bereits der erste Proxy-Host eingerichtet und mit einem kostenlosen SSL-Zertifikat von Let’s Encrypt versehen werden.

Wer den NGINX Proxy Manager mit einer Domain verwendet, muss zuvor den entsprechenden Record in seinen DNS-Einstellungen anlegen. Andernfalls wird nicht nur die ACME-Challenge für die Ausstellung des SSL-Zertifikats fehlschlagen, sondern auch die Weiterleitung nicht funktionieren. Bei einer DDNS-Adresse entfällt dieser Schritt. Da die SSL-Zertifikate jedoch jeweils nur eine Gültigkeit von 90 Tagen haben, verlängert der NPM diese entsprechend automatisch. Sollte es hierbei zu Problemen kommen, erhält der Nutzer eine Benachrichtigung per E-Mail.

Optional können nach erfolgreicher Einrichtung eines Hosts auch Zugriffsbeschränkungen für die entsprechende (Sub-)Domain angelegt werden. Diese erstellt NGINX auf Basis der HTTP Basic Authentication. Beim Aufruf der entsprechenden Adresse erscheint dann eine Abfrage nach Benutzername und Passwort.

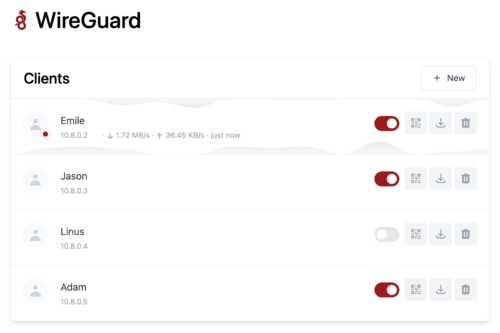

Sichere Verbindung ins Heimnetz – WireGuard hilft

Bereits seit 2015 mischt WireGuard den Markt der VPN-Dienste immer mehr auf und verdrängt in verschiedenen Bereichen die Platzhirsche OpenVPN und IPSec. Der Vorteil des Dienstes liegt vor allem in der geringen Anzahl an Konfigurationsoptionen, was eine schnelle Implementierung ermöglicht. Darüber hinaus verwendet WireGuard moderne Verschlüsselungsstandards, die eine Kompromittierung des Netzwerks so schwer wie möglich machen sollen. Da es sich um eine Open-Source-Entwicklung handelt und von zahlreichen Entwicklern unterstützt wird, kann es aus heutiger Sicht als das VPN-Protokoll der Zukunft angesehen werden.

Für eine schnelle und einfache Einrichtung von WireGuard bietet sich bei Verwendung von Docker der Container WG-easy an. Soll WireGuard, aus welchen Gründen auch immer, nativ auf dem Hostsystem betrieben werden, bietet PiVPN eine einfache Installation und Administration über die Kommandozeile. Im Gegensatz zu WG-easy bietet PiVPN jedoch von Haus aus keine Client-Verwaltung über das Web.

Natürlich ist dieser VPN-Dienstnur bedingt, mit kommerziellen VPN-Diensten vergleichbar ist, allerdings bietet er zumindest für die Nutzung in öffentlichen oder fremden Netzwerken eine verschlüsselte Verbindung. Wer mit seinem eigenen WireGuard eine VPN-Verbindung in ein fremdes Land aufbauen möchte, um zum Beispiel Geoblocking zu überwinden, benötigt hierzu im Wunschland einen entsprechenden Server, welcher den Dienst hosten kann. Danach steht aber einer Verbindung in die USA, Kanda oder in eines der zahlreichen Länder Asiens nicht mehr im Wege.

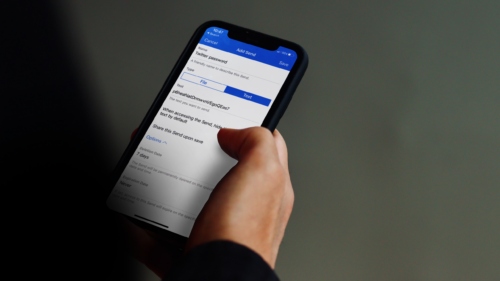

Bitwarden: Der Passwort-Manager

Sichere Passwörter und Zwei-Faktor-Authentifizierung sind inzwischen eigentlich Pflicht, wenn man sicher am digitalen Leben teilnehmen möchte. Hier kommt nun Bitwarden ins Spiel. Mit dem Passwort-Manager lassen sich nicht nur alle Zugangsdaten, welche hoffentlich für jeden Dienst individuell genutzt werden, speichern. Optional lässt sich auch die Zwei-Faktor-Authentisierung, kurz 2FA, mit einrichten. Ich persönlich habe mich aber aus diversen Gründen gegen die Integration in den Passwort-Manager entschieden. Hinzu kommt, dass diese Funktion bei der Nutzung von Bitwarden ein Premium-Abo voraussetzt.Alternativ verwendet den ebenfalls unter Open Source verfügbaren Fork Vaultwarden. Dieser bringt dieselbe Funktionalität wie Bitwarden mit sich, gewährt dem Nutzer zudem allerdings die kostenfreie Nutzung aller Premium-Elemente. Der Nachteil an Vaultwarden: Der Dienst ist nur im Selfhosting verfügbar. Über ein Docker-Stack ist Vaultwarden allerdings schnell installiert und eingerichtet.

Unabhängig davon, ob man sich für Bitwarden oder Vaultwarden entscheidet, gibt es in beiden Fällen eine Sache, die nicht vergessen werden darf. In der mobilen bzw. Desktopanwendung muss die Adresse (z. B. https://vault.eigene-domain.tld) auf jene des eigenen Servers entsprechend angepasst werden. Danach lässt sich der neue Passwort-Manager bereits auf den eigenen Geräten nutzen. Trotzdem empfehle ich dringend sich mit weiteren Einstellungen von Bitwarden, zum Beispiel Loginbenachrichtigungen oder dem Notfallzugang auseinandersetzen. Und wie immer gilt: Ein regelmäßiges Backup ist Pflicht.

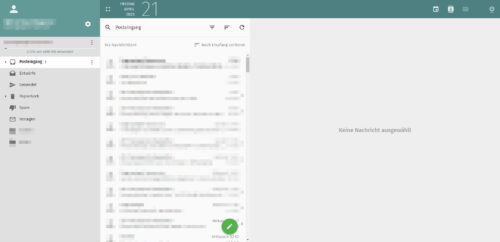

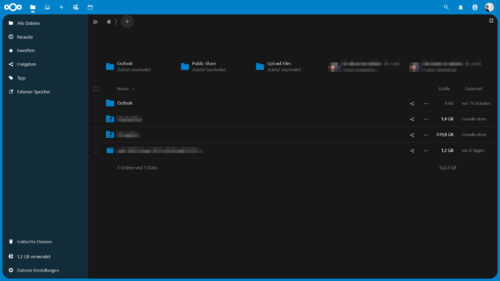

Weg von OneDrive und Co? Nextcloud kann eine Lösung sein

In Diskussionen über Cloud-Dienste höre ich vor allem immer wieder, wie schlecht doch die eigenen Daten bei Unternehmen wie Microsoft, Dropbox oder Google aufgehoben sind. Warum also nicht eine eigene, dezentrale Cloud-Instanz betreiben? Nextcloud macht es möglich. Im Gegensatz zu den bisher vorgestellten Diensten gibt es Nextcloud auch als Managed-Hosting-Angebot bei verschiedenen Dienstleistern. Eine Installation auf reinem Webspace ist ebenfalls möglich, aber nicht empfehlenswert. Denn hier fehlt der Zugriff auf die Kommandozeile, mit der man im Notfall eine gecrashte Cloud-Instanz wiederbeleben könnte.

Neben der reinen Datenspeicherung bietet Nextcloud von Haus aus aber noch deutlich mehr Funktionen. Soll es zum Beispiel ein eigenes Online-Office sein? Kein Problem. Auch das Speichern und Verwalten von Kontakten und Kalendern bietet Nextcloud von Haus aus. Unter iOS lassen sich diese sogar bequem per Konfigurationsprofil aus der App heraus in bestehende Apps integrieren. Weitere Funktionen lassen sich bequem über den internen App-Store nachinstallieren.

Je nach Umfang der Nextcloud-Installation kann ein Raspberry Pi mit externer Festplatte ausreichen. Sollen jedoch regelmäßig Daten über das Internet ausgetauscht werden, empfiehlt sich eine leistungsfähigere Hardware. Zudem ist eine ausreichend hohe Uploadrate Pflicht, sonst kommt statt Freude an der eigenen Cloud schnell Frust auf. Was in der Planungsphase ebenfalls berücksichtigt werden sollte, ist die Größe des geplanten Speichers, der der Nextcloud maximal zur Verfügung stehen soll. Dieser sollte zudem am besten in einem RAID-Verbund aufgebaut sein, damit es im Fall der Fälle nicht zu Datenverlusten kommt.

Die Königsdisziplin: Der eigene Mailserver

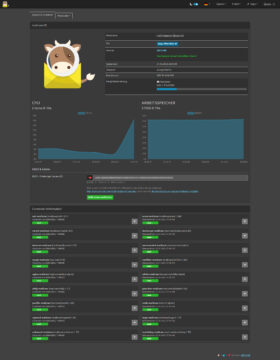

Die absolute Königsdisziplin in meiner Selfhosting-Reihe ist und bleibt bisher der eigene Mailserver. Diesen betreibe ich mit Mailcow, einem Groupware-Docker-Stack. Die Herausforderung dabei: Er muss nicht nur für einen selbst funktionieren, sondern auch für andere. Denn natürlich will man nicht nur Mails versenden, sondern auch empfangen. Entsprechend wichtig ist es gewissenhaft die Vorgaben der Installationsanleitung zu befolgen.

Mailcow ist Exchange aus Anwendersicht definitiv ebenbürdig

Aus eigener Erfahrung als langjähriger Nutzer von Microsoft Exchange würde ich Mailcow mit diesem aus Anwendersicht definitiv auf eine Stufe stellen. Allerdings hat Mailcow hier entscheidende Vorteile: Diese liegen nicht nur bei den Softwarekosten, sondern auch beim Konfigurations- und Wartungsaufwand sowie den Hardwareanforderungen. Hinzu kommt, dass Mailcow bereits von Haus aus zahlreiche Skripte mitbringt. Diese machen es dem Administrator der Serverinstanz recht einfach. Ich selbst lasse meine Instanz beispielsweise alle 15 Minuten vollautomatisch per mitgeliefertem Skript auf externem Speicher an einem anderen physischen Ort sichern. Ebenfalls bequem per Update-Skript lassen sich Updates einspielen, die etwa einmal im Monat erscheinen. Je nach Hardware und Verbindungsgeschwindigkeit ist dies eine Sache von wenigen Minuten und hat nur eine kurze Downtime des Dienstes zur Folge.

Neben der reinen Groupware-Funktionalität bietet Mailcow auch diverse Sicherheitsfeatures. Dazu gehören das Anti-Spam-Modul Rspamd, das Softwarepaket Netfilter sowie ein eigener ACME-Container. Darüber hinaus unterstützt Mailcow den Administrator bei der Konfiguration von Einstellungen wie DKIM, SPF und DMARC, die zwar optional, aber heutzutage fast obligatorisch sind. Auch andere DNS-Einträge, die die Einrichtung von Mail-Clients im späteren Betrieb erleichtern, werden von Mailcow direkt bereitgestellt. Diese müssen dann nur noch entsprechend den Vorgaben in der Domain-Verwaltung beim Domain-Provider hinterlegt werden.

Egal ob Browser oder Mailclient – Es funktioniert überall

Als Webmailer bringt Mailcow SOGo mit. An sich nicht wirklich aufregend, aber funktional. Natürlich lässt sich der Account von Mailcow auch in Outlook, Thunderbird und jedem anderen Mail-Programm nutzen. Für Nutzer von Apple-Geräten besteht auch hier wieder die Möglichkeit den kompletten Account per Konfigurationsprofil vollautomatisch auf dem Gerät einrichten zu lassen.

Wer sich den vollen Umfang von Mailcow einmal selbst anschauen möchte, hat an dieser Stelle Zugriff auf eine Demo-Installation, welche von den Entwicklern zur Verfügung gestellt wird. Mit den Logindaten admin – moohoo kann man sich dann entsprechend einloggen. Dies sind auch die Standard-Logindaten bei einer Neuinstallation.

Wer nun Gefallen an Mailcow gefunden hat, findet die Installationsanleitung an dieser Stelle. Alternativ kann Mailcow für Nutzer, welche sich den Betrieb nicht zutrauen, aber trotzdem einen eigenen Maildienst nutzen wollen, auch als Managed-Paket gebucht werden.

Fazit: Hat Selfhosting das Potential für die Masse?

Es gibt eine Reihe von Gründen, warum Menschen sich für Self-Hosting entscheiden. Dazu gehören eine bessere Kontrolle über die eigenen Daten, Sicherheit und Datenschutz sowie die Möglichkeit, bestimmte Anwendungen und Dienste anzupassen und zu optimieren. Doch auch diese Medaille hat zwei Seiten. Das Fazit meines Tests fällt daher leider negativ aus. Selfhosting ist nicht für jeden Nutzer eine sinnvolle oder gar praktikable Option.

Die Gründe dafür liegen auf der Hand: Hardware und Dienste einzurichten und zu betreiben erfordert nicht nur entsprechende Kenntnisse, sondern auch Zeit und den Willen, sich dauerhaft damit zu beschäftigen. Sollen die Dienste von den eigenen vier Wänden aus betrieben werden, stellt sich zudem gerade in Deutschland die Herausforderung einer zeitgemäßen Internetanbindung. Auch die mit dem Selfhosting verbundenen Kosten können auf Dauer eine Herausforderung darstellen. Hier sollte jedoch ein Vergleich mit Hosting-Diensten gezogen werden.

Leider kein Konzept für die Massen

Schließlich erfordert Selfhosting zeitaufwändigen und engagierten Einsatz. Einen Server einzurichten, zu warten und zu aktualisieren erfordert je nach Anzahl der Dienste einen erheblichen Zeit- und Arbeitsaufwand. Und natürlich muss neben dem Betrieb der Dienste und des Servers auch die Systemsicherheit gewährleistet sein. Wem schon hier die Zeit, das Wissen oder der Wille zur dauerhaften Administration fehlt, der sollte tatsächlich bei bestehenden Diensten bleiben oder wie im Falle von Nextcloud z.B. auf einen Hosting-Partner zurückgreifen. Selfhosting kann aber durchaus eine gute Alternative zu den etablierten Global Playern sein, wenn man all diese Punkte für sich positiv beantworten kann. Ich für meinen Teil werde die bestehenden Dienste, welche nun bereits seit geraumer Zeit nutze, weiterhin betreiben, da sie mir im Kosten-Nutzen-Verhältnis definitiv Vorteile bringen.

Wie sieht es bei euch aus? Betreibt ihr eure eigenen Dienste zu Hause oder auf einem Server in einem Rechenzentrum, oder seid ihr nach wie vor „klassisch“ bei den Global Playern verwurzelt? Oder habt ihr euch für eine ganz andere Strategie entschieden? Lasst es uns wissen und kommentiert.

>Die Königsdisziplin: Der eigene Mailserver

>

Klar, wenn ich meine Freizeit damit verbringen will anderen Diensten klarzumachen, das von meiner Domain kein Spam kommt, dann viel Spaß. Die eigentliche Installation eines Solchen auf dem privaten headless baremetal Server ist für jeden *NIX-User doch trivialo.

Addendum:

https://blog.fefe.de/?ts=a6d5d678

Scheint ech viel Spaß zu machen, so ein eigener Mailserver. Wenn selbst Profis die eigene IT-Security-Firmen besitzen das Problem haben.

Wenn man darauf keinen Bock hat nutzt man eben einen Upstream-Mailer (Mailrelay).

Oder man lässt es einfach bleiben und hat einen Dienstleister der sich rumärgert. Mal ganz ehrlich: Mit GPG/PGP und Freunden die das auch verwenden kann ich fast bei jedem E-Mailanbieter sein. Das eigentliche Problem ist das es keiner nutzen will.

Irrtum! Korrekten SPAM-Schutz können die Wenigsten.

Die Meisten, inkl. mailbox.org, lehnen SPAM nicht ab, sondern nehmen ihn an und werfen ihn dann weg, wahlweise versenden sie _nach_ Annahme einen Fake-NDR.

Das Problem dabei: Mit dem „200 OK“ Deines MX ist die Nachricht zugestellt*, rechtsssichere SPAM-Abwehr _darf_ deshalb abzulehnende Mails gar nicht erst annehmen, sondern muss das eingehende Mail während der laufenden Sitzung mit „5xy [frei wählbarer Text]“ zurückweisen.

* Analogie dazu aus dem RL:

Ein Brief, der in Deinem Briefkasten eingeworfen wurde ist „zugestellt“, völlig egal, ob Du ihn hinterher wegwirfst oder eine Postkarte „Hiermit weise ich Ihren Brief vom 22. April 2023 zurück!!!“ schickst.

Wichtig insb. für empfangsbedürftige Willenserklärungen.

Hätteste mal den Link gelesen statt gleich auf Antworten zu springen. Da werden selbst Unis mit einer ordentlichen DKIM-Signatur von Barracuda-Antispamfiltern blockiert 🤦♂️

Von daher ist der Erfahrungsbericht eines Hochschulrechenzentrums für mich relevanter. Die Betreuen locker mal 10000 – 80000 Accounts:

https://de.wikipedia.org/wiki/Liste_der_Hochschulen_in_Deutschland

Verstehendes Lesen ist nicht so Dein Ding, oder?

Den Server für _eingehende_ Mail betreibt man aus dem von mir genannten Grund selbst, _ausgehende_ Mails versendet man halt über einen Mailrelay.

Das Handling ein- und ausgehender Mail sind 2 völlig verschiedene Herausforderungen.

Oder mit dir zu reden ist einfach anstrengend und deswegen tun wir es nicht? Im Internet weiß man schnell mit wem man eine längere Unterhaltung führen will oder nicht.

Schönen Samstag und schönes WE

😂 Du tatest es gerade 😂

Hab auch ein schönes WE, bester Unterhalter 👍

Wissen hast du dennoch keines

Nextcloud benutze ich jetzt seit 2 Jahren auf meinem vServer.

Möchte ich nicht mehr missen. Ich kann da Musik und Videos reinladen und sie per Stream Plugin aufs Handy streamen, ohne den begrenzten HAndyspeicher voll zu knallen. Meine hochgeladenen Dokumente kann ich von überall bearbeiten, Kontakte synchronsieren. Ich bin sehr zufrieden damit.

Mailserver ist aber so ein Sache. Mailcow einrichten ist alles keine große Sache aber man landet zu 99% im Spamordner seines Gegenüber. Zumindest war das meine Erfahrung.

Da ich sowieso schon mailbox.org Kunde bin und man dort ja auch je nach Paket mehrere seiner eigenen Domains benutzen kann, realisiere ich den Mailverkehr darüber und das klappt super.

Nein. Selfhosting ist mit Sicherheit NICHT massentauglich. Dazu versteht der Durchschnittsuser viel zu wenig von der Computerei.

Ich sehe persönlich auch nicht den Grund dazu.

was ja auch nicht wirklich tragisch ist… die Welt da draussen besteht eben hauptsächlich aus Opfern! Und da die nichtmal merken das sie Opfer sind machen die sich auch keinen Kopf. Also ist doch alles in Ordnung!

Du selbst bist verantwortlich für alles was du tust und nutzt! Wenn Opfer zu sein für dich ok ist, dann ist das so… ansonsten setzt du dich eben mit der Technik auseinander. Real simple!

Keine Ahnung was dein Problem ist.

@Luzifer

👍

Züchtest du auch deine eigenen Lebensmittel? Bist du dein eigener ISP? Hast du ein eigenes OS entwickelt? Oder vielleicht kann nicht ein Mensch unmöglich alles machen und nach bestem Wissen und Gewissen Dienstleistern vertrauen. Ansonsten kann man sich sowohl Wirtschaft als auch Gesellschaft sparen und in einer Höhle leben.

Was hier für Uhus unterwegs sind …

Also mein eigener Server kostet im Gegensatz zur Dropbox keine 99€/Jahr. Von daher hat Luzifer einfach nur recht.

Naja, stimmt nur teilweise. ‚Dank‘ UPnP sind die UserInnen-Default-Ordner, wie Pictures, Documents etc, quasi von überall aus erreichbar. Sei es als Source das Handy, auf TV, PC, Laptop etc. Egal ob Android, Tizen, Linux oder MS Windows. Wenn dann an der (z.B.) Fritzbox die ‚automatische Portfreigabe‘ aktiviert ist (standard?), kannst’e rein theoretisch auch in der Deutschen Bahn (Witz !->) Deine, im Ordner Videos gelagerten, Home-Videos anschauen. Die Frage, die sich mir stellt, ob die Leute wissen, das es schon gewisse ‚automatische‘ Freigaben gibt, die mgl.w. halt auch ihre nicht ganz jugendfr… Egal Aufklärung tut in dieser Hinsicht zweifach Not

Aufklärung tut in dieser Hinsicht zweifach Not

PS.: AVM ‚warnt‘ ja nicht zu unrecht davor, Portfreigaben zu ‚automatisieren‘. Ich gebe z.B. nach der Regel: ALLOW host (hier IP meiner Hosts; darunter auch die IP vom TV); DENY for ALL (für alle weiteren Hosts) ‚Default-Ordner‘ frei. Übrigens ein witziges/reales Thema: Je schneller die Deutsche Bahn wird, desto schwieriger ist ein stabiler Verbindungsaufbau zum Internet…

Interessant, aber nichts was man pauschal betrachten kann.

Grundsätzlich scheitert es bei den meisten ja bereits daran, wenn etwas ein paar Euro kostet.

Warum also eine Domain, ein VPN, irgendein Gerät, ggf. Softwarekosten…

Zudem kann man das ja noch viel weiter führen und deutlich früher beginnen.

Welcher Internetanschluss?

Ggf. Kabelinternet mit DS-Lite und seinen Spezialitäten.

Welcher Router? Also gibt’s überhaupt die Möglichkeit und ist es laut AGB des Providers überhaupt erlaubt Dienste bereitzustellen (ganz unabhängig von privat und geschäftlich)?

Hat man eine eigene Entstörzeit, wer entstört wenn ich unterwegs bin und die Daten Zuhause brauche aber etwas nicht funktioniert?

Backup ist zudem für alles wichtig, aber was nimmt man denn da?

Man kommt daher immer weiter und Hand aufs Herz, wer hat dazu Lust und Zeit, wo man doch alles auch einfach halten kann.

Für die private Archivierung kann man dann auch noch ecoDMS ins Boot werfen, also ein weiteres System.

Hinzu kommt der Wandel der Zeit, gerade OpenSource wandelt sich ständig, ggf. springen zentrale Entwickler ab und machen auf einmal etwas eigenes (MySQL/MariaDB).

Bei OneDrive und Co. kümmern sich andere um die Migrationsplanung etc. einfach nur benutzen ist dabei angesagt.

seit letztem Jahr habe ich ein Synology NAS mit einer aufgesetztem Hyper-V Windows 11 Maschine laufen, auf die auch von unterwegs zugegriffen werden kann. Darauf dann Ofice 365 etc.

Einen eigenen MailServer brauche/nutze ich nicht.

Zur Zeit teste ich darüberhinaus die NAS Systeme von QNAP und Asustor, um mir ein Bild zu machen, wer Hardware/Software-mäßig die Nase vorn hat. Insbesondere die Smartphone/AppleTV-Apps sind da für mich interessant.

„Neben der reinen Datenspeicherung bietet Nextcloud von Haus aus aber noch deutlich mehr Funktionen. Soll es zum Beispiel ein eigenes Online-Office sein? Kein Problem.“

Was gennau ist damit gemeint? Welches Online Office ist das?

‚Selfhosting‘ wird meines Erachtens, dank fester IPv6 am eigenen ISP-Anschluss (bzw. Handy usw.), schneller Realität, als manchen Lieb sein mag. Um es noch krasser zu formulieren: Wozu brauche ich NextCloud, ‚OnlineOffice‘ usw., wenn ich meine NAS (quasi meine niedliche kleine Cloud im eigenen Intranet ) so konfigurieren kann, dass sie da erreichbar ist, wo ich gerade arbeite, wohne, schlafe, sitze, schnarche, reise usw? Beispiel: Firefox-Profil(-Ordner) und dessen sync kann auf die eigene NAS umgelenkt werden. Zugegeben, noch etwas zu ‚tricky‘. Mittlerweile sind auch der MS Edge Profile-Ordner und der von Chromium ‚umlenkbar‘, so dass zumindest meine Lesezeichen/Bookmarks sync sind. Wobei Chromium ständig (bei Firefox-Lesezeichen…) Unterordner anlegt. Da muss ich noch mal ran…

) so konfigurieren kann, dass sie da erreichbar ist, wo ich gerade arbeite, wohne, schlafe, sitze, schnarche, reise usw? Beispiel: Firefox-Profil(-Ordner) und dessen sync kann auf die eigene NAS umgelenkt werden. Zugegeben, noch etwas zu ‚tricky‘. Mittlerweile sind auch der MS Edge Profile-Ordner und der von Chromium ‚umlenkbar‘, so dass zumindest meine Lesezeichen/Bookmarks sync sind. Wobei Chromium ständig (bei Firefox-Lesezeichen…) Unterordner anlegt. Da muss ich noch mal ran…

Was Deine Frage betrifft: ‚OnlineOffice‘? Mir kommt da nur ein Kandidat in frage: OnlyOffice. Die Frage, die sich stellt, ob Du an einem Handy (Tablet vielleicht OK) eine größere Excel-Tabelle bearbeiten möchtest???? Was jedoch Verfügbarkeit betrifft, mein Vorschlag: Lokal ‚Excel-Tabelle‘ anlegen/bearbeiten, auf NAS speichern, und entspr. Ordner im Internet verfügbar machen. Wobei die Absicherung vielfältiger Natur sein können; Host-ALLOW/~DENY sind da nur eine Möglichkeit. Wenn’de Deinen eigenen WebServer im Internet verfügbar machen möchtest, sind konkrete Zugriffs-Rechte z.B. in der .htaccess bzw. .htpasswd recht interessant. Bei Fragen, gerne…

Was hat eine feste IP damit zu tun ob self-hosting geht? Wenn sich meine dynamische IP ändert wird dank updater script der DNS-Eintrag über DynDNS /NoIP direkt der auf die neue IP angepasst. Die „downtime“ von Sekunden.. nachts um 03:20 bei IPv4-Wechsel merke ich sowieso nicht wenn ich im Bett friedlich schlafe.

Betreibe self-hosting seit 16 Jahren ohne Probleme. Feste IP ist ein meme um Geld zu melken. Das brauchen nur Firmen. Das Kunden es nicht haben ist ganz gut für die Privatssphäre, denn die Privacy-Extensions bei IPv& bringen fast nichts in der Realität:

https://www.heise.de/news/Trotz-Privacy-Extensions-IPv6-Adressen-fuer-andauerndes-Tracking-nutzbar-7186203.html

Schöner Artikel, schöne Zusammenfassung. Was mir persönlich etwas fehlt ist der Hinweis auf die Gefahren des Selfhosting. Nicht ausreichende Kenntnisse, vor allem wenn es um Server „im Internet“ geht oder daheim von extern erreichbar.

Es wird viel zu viel Copy & Paste Administration betrieben was dafür sorgt das es so viele leicht angreifbare Ziele gibt. Bei einer Ansammlung div. Dockerlösungen erst recht weil es einfach schnelles klicki klicki ist und viele dann aber keine Ahnung von dem hinten dran haben bzw. der Basis.

Ich bin ein verfechter beider Parteien. So habe ich Nextcloud bzw. damals noch Owncloud lange Zeit benutzt, bin dann aus bequemlichkeit zu Synology gewechselt da mit der DSM7 einfach so gute Features gekommen sind bzw. bestehende Features endlich richtig gut umgesetzt wurden.

Auch Syno bietet mir inzwischen theoretisch alles was ein KMU benötigt und damit auch alles was man privat benötigen könnte wenn es um eine Groupware „extended“ Lösung geht.

Unabhängig davon haben wir für die Family z.B. trotzdem einen eigenen Microsoft Tenant mit MS365 laufen für Teams (mit allen Funktionen), Exchange Online für Mails & Kalender, OneDrive selbstredend etc.

Was an der Kombi besonders schön ist, meiner Meinung nach. Ich kann entscheiden was ich daheim und was ich bei MS speichere und hab trotzdem mit beiden Lösungen immer und überall Zugriff darauf, auch auf allen erdenklichen Geräten.

Zusätzlich kann ich über das Synology sämtliche MS365 Inhalte sichern ohne Mehrkosten. Den Exchange, Sharepoint, OneDrive selbst die Teams Chats / Files.

Für mich war bzw. ist das die angenehmste Mischung aus „private Cloud“, Usability für zusätzliche Member (Family), Datensicherheit bzw. Backup Möglichkeiten und möglichst einfache Administration mit wenig Wartungsaufwand.

Ich habe seit rund 10 Jahren ein eigener Server. Für die Administration der VM ist Proxmox im Einsatz. Gemountet ist Ubuntu als Betriebssystem. Für die Netzwerkadministration setzte Nginx ein. Auch eine private Cloud ist gefährdet. Da habe ich mein Grundsatz: hochwertige private Dokumente haben so oder so in der Cloud (intern/extern) rein gar nichts verloren. Gehostet ist Nextcloud und im gegenwärtigen Test ist OnlyOffice. Am späteren Abend fährt der Server herunter – am Vormittag ist dannzumal der Start. Genutzt wird der Server von der Familie und einige Kolleginnen und Kollegen. Die Arbeit um die Serversicherheit ist nie beendet – mit neuen Tools oder eigene neuen Ideen erreiche ich eine ordentliche Sicherheit. Für mich ist das ganze ein Lehrpfad und das macht Spass.

Ich benutze für meine Dienste zu Hause einen Rasperry PI 4 B 8GB, darauf habe ich einen Medienserver und PI-Hole (Werbeblocker) in Docker installiert. Ein VPN ist das nächste Projekt. Über Selfhosting habe ich mir noch keine Gedanken gemacht, aber ist ein interessantes Thema. Mal schauen inwieweit mei PI damit umgehen kann. Ein „richtiges“ NAS von Synologie oder Qnap benötige ich für meine Zwecke nicht. Außerdem ist der Stromverbrauch vom Rasperry unschlagbar, muss man ja leider heute auch drauf schauen😂

Gott sei dank hab ich den PI noch gekauft bevor er so Arschteuer wurde.

gepostet mit der Deskmodder.de-App für Android

Der Pi 4 kann grundsätzlich gut als „kleines NAS“ (Samba) oder als eigene Cloud (Nextcloud) dienen, allerdings hängt es auch von dem internen Aufbau deines LANs ab. Und nicht vergessen: die schnellste Schnittstelle um Daten zu speichern bleibt halt einer der beiden USB3 Ports. VPN – idealerweise eine Wireguard-Instanz – lässt sich prima mit dem vorhandenen PiHole und dessen DNS- sowie DCHP-Server-Funktionen kombinieren, ist also ebenfalls eine gute Idee. Aber auch hier: Bandbreite beachten, diesmal nicht im eigenen Netz, sondern nach draußen und von draußen rein. Das ist beispielsweise in meinem Fall der Grund, warum ich mein VPN von außerhalb nur selten nutze, was es… naja, nicht allzu sinnig macht.

Was den Mailserver angeht? Das ist mir zu heikel. Selbst große Hoster haben oft Probleme, wieder von diversen Sperrlisten zu kommen. Den Stress werde ich mir nicht antun. Abseits davon hab bis auf Bitwarden im Kern die gleiche Funktionalität, wenn auch nicht mit der gleichen Softwarebasis auf meinem Pi laufen wie der Artikelautor. Allerdings nicht in Docker-Containern sondern nativ.

Erstmal danke für die tolle Übersicht 👍🏻

Ich nutze die oben genannten Dinge bis auf MailCow, alles zu Hause gehostet auf meinem Server. Gesamt: opnSense mit Wireguard, Windows Domain Controller, NGINX Proxy Manager, Windows Print-Server, CUPS Print-Server, Webserver, Windows Server für lokale SMB-Shares, Vaultwarden, NextCloud, Veeam, Download-Server (JDownloader + Torrent), Uptime Kuma, Windows Admin Center, Unifi Controller, FTPS-Server, Paperless-ngx, eigene Suchmaschine (SearX), ArchiveBOX [Web-Archivierung], draw.io, pastefy, YOURLS Link-Kürzer, Veeam Backup-Server

Der klare Vorteil (m.M.n) ist die volle Kontrolle darüber und die Erweiterbarkeit (gerade was Speicherplatz angeht).

Man muss aber auch sagen, viele DInge sind nicht sonderlich anwendertauglich. Höchstens über so Dinge wie YunoHost, das kann man ja relativ einfach aufsetzen. Aber einfach nicht für jedermann.

Ein normaler Benutzer hat ja wahrscheinlich gar nicht so ein großes Interesse, um das alles umzusetzen (Ich bin bspw. ITler und beschäftige mich auch gern damit).

Gesamt eine schöne Zusammenfassung, aber fast jeder wird weiterhin bei den „Global Players“ bleiben, weil es einfache und bequem ist.

Habe mehrere RPi mir Nextcloud und Minecraft.

Bis jetzt lauft alles ganz gut.

Ich würde mir noch wünschen, Matrix Server der auf dem RPi lauffähig ist.

Das kann man auch Discord in den ar… treten.

Der Fairness halber sollte man Mailcow ausklammern. Das Setup an sich ist relativ einfach, die Fallstricke (wie bei jedem Mailserver bzw. SMTP) allerdings zahlreich.

Stichworte:

– statische IP aus einem „sauberen“ Adressbereich

– rDNS Eintrag für den eigenen Anschluss

– die Konfiguration der Härtungen für Hobbyadmins (DMARC, DKIM, SPF & Co) mitunter schwer verständlich

Das nur mal am Rande.

Ich habe einen eigenen Mailserver. Ich glaube es ist das Zeug von MS.

Man braucht nur einen Domain-Namen und ein Hosting-Abo und kann dann E-Mail Adressen einrichten. Mail only gibt es in der Zwischenzeit auch, wenn man keine Webseiten hat.

Grins…

„Ich glaube, es ist das Zeug von MS“ Also wahrscheinlich hosted Exchange? Das ist in dem Sinne kein eigener Mailserver. 😉

Aha.

Wie sagt man dieser Sache dann?

Selfhosting ist sicherlich nicht massentauglich. Ich selbst nutze alle im Beitrag genannten Lösungen (Bitwarden, Nextcloud, Mailcow). Ich selbst habe seit einigen Jahren einen eigenen Mailserver mit Mailcow. Wenn man sich mit der Materie auseinandersetzt (DKIM, SPF, MTA-STS usw.) funktioniert das problemlos – auch ohne Relay. Anfangs hatte ich lediglich einige Probleme mit outlook Adressen. Das scheint anderen professionellen Anbietern auch so zu ergehen. Anonsten ist Mailcow wirlich nutzerfreundlich und recht einfach zu administrieren.